- techy

- Posts

- 🤖 È tutta una questione di incentivi

🤖 È tutta una questione di incentivi

Buongiorno! Questo è techy, lo spazio che ti aiuta a navigare la rivoluzione tecnologica che stiamo vivendo!

Ecco cosa offre il menù di oggi:

🤖 È tutta una questione di incentivi

💣️ L’AI non comprende la de-escalation

Ma prima…

🇩🇪 Uber e Momenta testeranno veicoli autonomi in Germania nel 2026

I test inizieranno a Monaco e inizialmente con operatori di sicurezza a bordo. Momenta, fondata nel 2016, è leader in Cina nei veicoli autonomi. La partnership sfida Lyft-Baidu che parte nel 2025 in Germania e UK

🛩️ Supernal, la startup di taxi volanti elettrici, ha sospeso le attività

Sospeso il programma di volo dopo l'uscita di CEO e CTO. L'azienda aveva completato il primo volo di prova quest'anno. Previsto per il 2028, il lancio commerciale è ora incerto. La società ha anche licenziato dipendenti e chiuso la sede di Washington

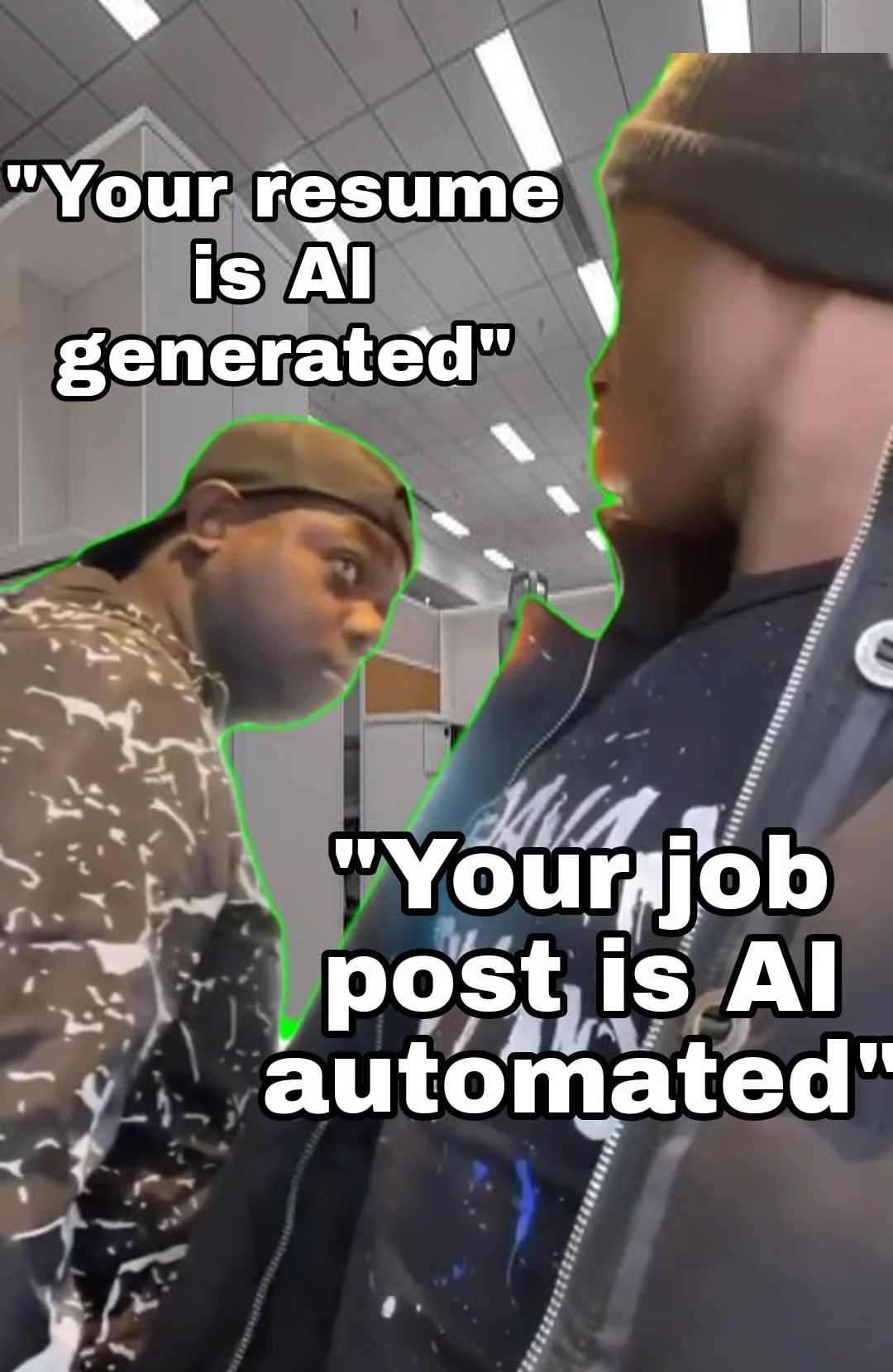

🤖 È tutta una questione di incentivi

I ricercatori di OpenAI hanno cercato di capire una volta per tutte perché i chatbot AI come ChatGPT a volte inventano informazioni false ma credibili (le famose "allucinazioni").

La loro conclusione è che il problema sta nel modo in cui valutiamo questi sistemi.

Quando valutiamo i modelli AI con test che danno 1 punto per la risposta giusta e 0 punti per "non lo so", stiamo incentivando il modello a tentare sempre una risposta, anche quando non è sicuro.

È come se insegnassimo a uno studente che è meglio sparare a caso una crocetta in una domanda a risposta multipla qualcosa piuttosto che lasciare in bianco.

Insomma, le valutazioni attuali penalizzano chi si astiene.

Il problema nasce già nel pre-addestramento: i modelli imparano da testi senza etichette vero/falso, rendendo difficile distinguere affermazioni valide da quelle errate.

Per fatti arbitrari come compleanni o dettagli specifici, dove non esistono schemi nei dati, gli errori sono statisticamente inevitabili.

La soluzione proposta da OpenAI è semplice.

Modificare il modo in cui vengono valutati i chatbot e penalizzare gli errori piuttosto che l'incertezza. Con i giusti incentivi, i modelli potrebbero imparare a dire "non lo so" quando appropriato.

Trasformazioni rigide 📐

Ecco come usare il modello Nano Banana di Google per ricreare qualsiasi stanza o ambiente in vista isometrica.

Ottieni una prospettiva a volo d'uccello che rivela dettagli nascosti e crea immagini perfette per mockup di contenuti e design.

Passo dopo passo:

Vai su gemini.google.com e selezionate l’icona “🍌Immagine”

Carica una foto di una stanza qualsiasi e scrivi "Ricrea questa immagine in vista isometrica"

Con ulteriori prompt puoi anche perfeziona gli elementi: "Rendi la stanza più grande", "Aggiungi il tema punk rock con un lampadario minimalista" (Nano Banana modifica senza rigenerare l'immagine)

Puoi anche cambiare l’ambiente: "Cambia la finestra con paesaggio urbano in vista sull'oceano" o "Aggiungi la luce naturale del sole e una porta per un'altra stanza"

E se vuoi spingerti oltre, carica l'immagine modificata su VEO e inserisci questo prompt "Rendi vivace questa stanza aggiungendo due cani che corrono"

Fonte: TheRundownAI

💣️ L’AI non comprende la de-escalation

Gli esperti di sicurezza sono preoccupati per l'integrazione dell'AI nei sistemi militari.

Come tutti noi usiamo l'IA per aiutarci a prendere decisioni, così anche generali e militari la stanno usando per scelte cruciali.

I rischi sono 2:

in futuro l'IA potrebbe avere il potere di lanciare bombe da sola

i comandanti potrebbero fidarsi ciecamente dei suoi consigli (sbagliati)

Il problema è molto grave anche per un altro motivo: nei test di guerra simulata, l'AI peggiora sempre i conflitti invece di calmarli.

"L'IA comprende l'escalation ma non la de-escalation"

E nessuno capisce perché.

Il Pentagono non ha regole chiare su come usare l'IA con le armi nucleari e nel frattempo Trump ha chiesto più AI nel governo ma meno controlli di sicurezza.

Il Pentagono promette che ci sarà sempre una persona a decidere, ma gli esperti temono che questa promessa sparirà nel tempo.

Il futuro un sistema AI difettoso potrebbe davvero causare una guerra per errore? Gli scenari da film di fantascienza stanno diventando realtà.

🇺🇸 La SEC statunitense svela il programma per rivedere le politiche sulle criptovalute

🇿🇦 La sudafricana Altvest raccoglierà $210 milioni per acquistare Bitcoin

🎧 Crea effetti sonori da prompt di testo (ElevenLabs SFX v2)

🌎 Modello di mondo AI per ambienti 3D esplorabili (HunyuanWorld-Voyager)

Se ti hanno inoltrato questa mail, iscriviti qui!

Ti è piaciuta la news di oggi? :)Diccelo con un commento! |